Avec l’essor des usages de l’IA, les infrastructures d’entreprise sont confrontées à de nouveaux défis : scalabilité, sécurité, pilotage des coûts. Concevoir une architecture adaptée devient une priorité.

Comment structurer son environnement technique pour accompagner ces nouveaux besoins ? Par où commencer ? Quels pièges éviter ?

Pour éclairer ces enjeux, nous avons interrogé Brice Geoffroy et Benjamin Messiaen, Architectes Systèmes chez Inside, qui partagent leur retour d’expérience et leurs conseils pratiques.

Le terme « infrastructure IA » recouvre des réalités différentes… quelle est votre définition ?

Brice Geoffroy : En effet, les définitions d’une infrastructure IA varient. Chez Inside, nous considérons l’infrastructure IA comme le socle sûr et fiable permettant d’héberger et d’administrer toutes les briques technologiques liées à l’IA.

Benjamin Messiaen: Ce socle intègre ainsi différentes ressources et services pour entraîner, exploiter et maintenir des applications d’IA de manière sécurisée, scalable et pérenne. Il est aussi essentiel de rappeler qu’une infrastructure IA n’est pas monolithique. Elle doit s’adapter aux usages : un chatbot interne, une architecture multi-agents ou des systèmes de prédiction en temps réel n’ont pas du tout les mêmes exigences techniques.

Quelles sont les différents composants technologiques d’une infrastructure d’IA ?

Benjamin : Structurer une infrastructure adaptée à l’IA, c’est assembler plusieurs briques technologiques qui doivent travailler ensemble de manière fluide et sécurisée.

La première couche, c’est le calcul ou Compute: GPU, CPU haute performance, TPU… Selon les modèles IA utilisés, les besoins en puissance varient énormément.

Ensuite, vient le stockage. L’IA nécessite d’accéder à des volumes massifs de données, avec des exigences de latence souvent fortes et des solutions capables de gérer des stockages objets (ex : stockage d’objets Blob).

Sur le plan data, un point clé est la gestion des bases de données. Ce n’est plus uniquement SQL ou NoSQL comme dans les architectures traditionnelles, il faut également – selon les usages – intégrer des Vector DB pour stocker efficacement les embeddings et soutenir des logiques de Retrieval Augmented Generation (RAG).

Pour orchestrer tout cela, l’automatisation devient indispensable. L’utilisation par exemple de Docker pour la conteneurisation et de Kubernetes pour l’orchestration des services IA est courante. Cela assure la scalabilité, la portabilité et une gestion simplifiée des déploiements IA.

Brice : Un autre élément majeur de l‘architecture, c’est le middleware. Dans une infrastructure IA, il est essentiel d’avoir des couches d’interface entre les utilisateurs et les modèles IA, pour filtrer, réguler, et structurer les interactions.

Eh bien sûr la sécurité ! IAM, RBAC, chiffrement des flux et des données : tout doit être intégré nativement. D’autant plus que l’IA peut être détournée facilement si les droits et les accès ne sont pas parfaitement maîtrisés. La gouvernance et le monitoring sont également à prendre en compte dans la conception de l’architecture dès le départ, pour auditer, sécuriser et piloter l’usage de l’IA dans l’organisation.

A cela s’ajoute une spécificité forte des projets IA : le pilotage budgétaire. Il doit – selon nous – devenir une brique d’architecture à part entière.

Comment fonctionne un agent d’intelligence artificielle ?

Un agent IA fonctionne sur le principe perception-action. Il reçoit une entrée (une donnée, une requête utilisateur, un signal d’un autre agent), analyse cette information via son modèle d’IA, puis génère une réponse ou une action.

Dans une architecture multi-agents (SMA), plusieurs agents collaborent de manière séquentielle ou parallèle. Chaque agent joue son rôle spécifique et l’objectif du SMA, contrairement aux agents isolés, c’est de les faire collaborer ensemble. Le système peut alors être optimisé (souvent quand les tâches sont consécutives) avec un agent superviseur qui assure le contrôle et la coordination. Par exemple :

- Un agent collecteur récupère et structure les données.

- Un agent analyste interprète les données et en tire des conclusions.

- Un agent générateur produit du contenu ou une réponse actionnable.

- Un agent fact-checker valide la cohérence et la conformité des informations.

- L’agent superviseur orchestre et ajuste ses actions en fonction du contexte et des priorités.

Cette architecture permet d’optimiser les performances, de garantir une meilleure supervision et d’éviter les erreurs courantes des IA isolées.

Un SMA bien conçu, c’est comme une équipe projet efficace : chaque membre joue son rôle et le superviseur est le Chef de Projet qui assure la cohérence d’ensemble.

Pourquoi cette brique de pilotage budgétaire est essentielle dans les infrastructures IA ?

Brice : Contrairement à une application classique, l’Intelligence Artificielle a un comportement de consommation dynamique : un modèle peut générer des charges de calcul très variables selon les données ou les utilisateurs. Sur des environnements full cloud, par exemple, un traitement IA mal maîtrisé peut entraîner une explosion des coûts sans que cela soit immédiatement visible dans le monitoring classique.

Chez Inside, nous préconisons donc de rendre la consommation IA spécifiquement visible, avec des outils d’alerting et de supervision budgétaire dédiés.

Cela concerne aussi bien le Cloud public (ex : suivi de la consommation GPU par projet IA spécifique sur Azure) que l’On-Premise, où il est indispensable de suivre le ROI du matériel déployé (investissement GPU/TPU) au regard de l’usage réel.

Benjamin: Oui, cette dimension est une conviction forte chez Inside. Le pilotage budgétaire et le monitoring sont indissociables de la gouvernance IA. Il s’agit non seulement de maîtriser les coûts, mais aussi d’analyser les comportements d’usage et les biais possibles en conséquence : quelles équipes sollicitent les modèles ? Quelle température de réponse est paramétrée par défaut ? Y a-t-il des dérives en termes de sollicitations API ?

Ce point est d’autant plus important que l’IA n’obéit pas à un algorithme strict comme les logiciels traditionnels. L’IA va chercher à répondre coûte que coûte, parfois en outrepassant les limites initiales si l’infrastructure ne met pas des garde-fous solides.

C’est un changement de paradigme : c’est désormais l’infrastructure qui doit garantir les contraintes, pas seulement le code applicatif !

Quels conseils donneriez-vous à une entreprise qui souhaite initier plusieurs projets IA, mais ne sait pas par où commencer sur le plan infrastructure ?

Benjamin : Le premier conseil est simple : il ne faut pas mettre en place des solutions IA pour le principe de faire de l’IA. Il existe encore aujourd’hui beaucoup de dérives dans ce sens. Dans certains cas, des approches plus classiques, basées sur des logiques déterministes, peuvent s’avérer plus efficaces qu’un modèle IA coûteux à entraîner et complexe à piloter.

La première étape est donc de clarifier les cas d’usage, via un dialogue étroit avec les métiers, pour comprendre où l’IA apporte réellement une valeur.

Brice : C’est aussi pour cela que chez Inside, nous ne vendons pas d’infrastructure IA « clé en main ». Ce type d’approche rigide devient rapidement obsolète face à l’évolution très rapide de ce domaine et des technologies. Nous avons bien sûr des préconisations sur l’architecture macro nécessaire, mais le choix de chaque brique dépend toujours du contexte du client.

Notre conviction, c’est donc de commencer dans tous les cas par un audit du contexte du client et de ses cas d’usages – y compris sur la capacité de l’équipe en place à accueillir l’infrastructure IA – pour définir l’architecture qui sera adaptée.

Plutôt qu’une architecture clé en main figée, nous construisons des infrastructures IA évolutives, adaptées à chaque cas d’usage, en lien direct avec les besoins et les capacités de l’organisation.

Quels sont alors les facteurs clés à analyser dans la phase d’audit initial du contexte ?

Brice : En premier lieu, il faut partir des cas d’usage métier et des priorités de l’entreprise : c’est cela qui va guider les choix d’architecture. Nous prenons aussi en compte la stratégie technologique portée par la DSI qui va conditionner certains arbitrages techniques (infrastructure actuelle, partenariats technologiques, Cloud, hybride ou On-Premise…) et analysons la sensibilité des données manipulées ainsi que niveau de sécurité cible, pour cadrer les enjeux réglementaires. Enfin, nous regardons le niveau d’intégration souhaité entre les futurs services IA et le SI existant.

Benjamin : Nous attachons également une grande importance à l’analyse des compétences internes (DevOps, IA…). Il faut s’assurer que les équipes sont capables de l’exploiter, de la maintenir et de la faire évoluer.

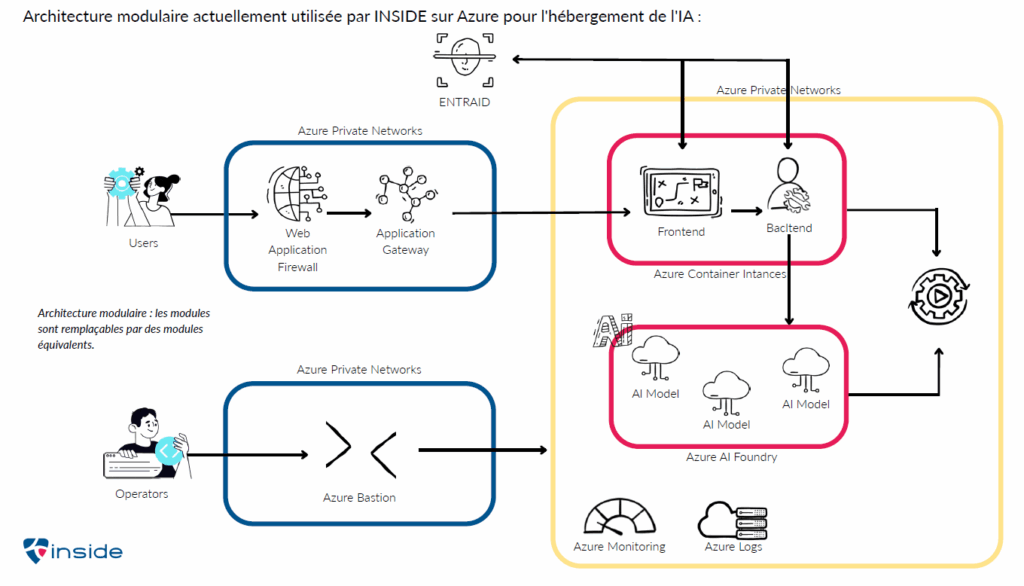

C’est ce diagnostic qui nous permet ensuite de sélectionner les technologies les plus pertinentes brique par brique. L’architecture cible reste globalement structurée de la même manière comme sur le schéma ci-dessous : ce sont les choix technologiques qui varient selon le contexte client. Cette approche agnostique permet de garantir un maximum d’agilité, et de faire évoluer les composants de manière dans le temps.

Quels sont les signaux d’alerte qui montrent qu’une infrastructure IA est mal dimensionnée ?

Benjamin : Des temps de réponse trop longs, une latence excessive ou des modèles impossibles à déployer de façon fiable sont les symptômes d’une architecture qui ne tient pas compte des spécificités de l’IA.

Le second point d’alerte, ce sont les surcoûts Cloud. L’IA est très consommatrice. Sans un suivi budgétaire dédié et des alertes en place, les coûts peuvent très vite devenir incontrôlables.

Brice: Une absence de logs ou d’alertes est également un signal critique. Il faut être en mesure de tracer ce que font les modèles, comment ils sont sollicités et si leur comportement évolue. Enfin, les cas les plus sensibles concernent la sécurité : API exposées, IAM mal configuré, absence de supervision… Une IA non encadrée peut générer des biais, divulguer des informations ou sortir de son périmètre fonctionnel. C’est le rôle de l’architecture de fixer ces limites.

Prenons un premier cas: une PME souhaite intégrer un assistant conversationnel interne, n’utilisant pas de données sensibles. Quelle infrastructure recommandez-vous dans ce cas ?

Brice : Pour des cas d’usage simples et sans traitement de données sensibles, il est inutile de complexifier. Nous recommandons une solution 100 % cloud public, simple à mettre en œuvre, sécurisée, et avec un budget très maîtrisé. L’idée, c’est de démarrer rapidement, avec des briques existantes, sans surinvestir.

Dans ce cas, un assistant basé sur un service SaaS comme Microsoft 365 Copilot ou Google Gemini peut suffire. Si l’objectif est plus spécifique, on peut envisager un usage encadré d’Azure OpenAI ou un RAG léger connecté à un outil de stockage documentaire comme SharePoint ou Google Drive.

Benjamin : Ce qui pilote les choix dans ce type de contexte, c’est clairement le budget et l’intégration dans les outils bureautiques existants ! Inutile de développer ou maintenir une architecture spécifique si l’usage est limité à une assistance interne sur des données génériques. Cela vaut pour une PME comme pour une grande entreprise.

Si les données ne sont pas sensibles, notre recommandation, c’est de faire au plus simple et au plus léger en minimisant les coûts.

Et dans le cas de la mise en place d’une architecture d’agents IA – à fort besoin de scalabilité et de vitesse de réponse – exploitant des bases de connaissance techniques internes et des bases de données clients ?

Brice: Dans un cas comme celui-ci, on change complètement d’échelle. Il faut penser scalabilité, vitesse de réponse, et maîtrise des données sensibles – notamment les bases clients, historiques de ventes ou documents techniques internes. L’infrastructure IA doit reposer sur une segmentation fine du réseau, avec une couche de micro-segmentation entre les services IA et les autres briques du SI.

Nous mettons également en place une couche middleware dédiée, qui isole les échanges entre les modèles et les utilisateurs, et permet de tracer tous les flux via les logs. C’est ce qui garantit à la fois la performance, la sécurité et la supervision.

Benjamin : Ce type de projet nécessite une vraie industrialisation de l’infrastructure : CI/CD, monitoring avancé, gestion des logs, orchestration par conteneurs… Nous nous appuyons sur des outils comme Azure AKS, Cognitive Search, OpenAI, mais chaque choix dépend du contexte technique du client. C’est là que notre approche chez Inside fait la différence : nous auditons l’existant et les compétences internes pour concevoir une architecture sur-mesure. Est-ce que l’environnement est plutôt Linux ? Microsoft ? Quels outils sont déjà en place ? Nous adaptons les briques sans dogme technologique.

C’est dans ce type de projets IA que nous apportons le plus de valeur ajoutée sur tout le cycle : conception de l’architecture, développement, industrialisation et MCO de l’infrastructure.

Et dans le cas d’une entreprise européenne du secteur de la défense, devant répondre à des contraintes de souveraineté critique ?

Benjamin Messiaen : Ici, le niveau d’exigence change encore. Il faut basculer sur un hébergement full privé ou un cloud souverain certifié SecNumCloud, comme Bleu, OVH SCSN ou Outscale. Aucun accès internet ne doit être autorisé par défaut dans les environnements IA, et chaque brique doit respecter les standards de souveraineté – du stockage aux modèles IA, comme Mistral.

Brice Geoffroy : Cela implique aussi des contraintes de sécurité, de documentation et de coût beaucoup plus fortes. Chaque action doit être traçable. Il faut fournir des dossiers d’architecture, des analyses de sécurité, et intégrer le RSSI dans chaque étape du projet. La conformité ANSSI exige un travail rigoureux, continu et de tout documenter.

Benjamin Messiaen : L’impact est également fort sur le RUN. L’administration à distance est restreinte, parfois impossible. Les équipes de maintenance doivent souvent travailler en local, dans des environnements isolés, avec des règles d’authentification renforcées. Cela change tout en matière d’externalisation : pas de mutualisation, pas d’improvisation. Dans les projets avec ce niveau de criticité, nous menons systématiquement un cadrage préalable avec le RSSI pour définir les règles à appliquer et les contraintes légales.

Comment Inside intervient concrètement aux côtés de ses clients pour définir, mettre en œuvre et faire évoluer leur infrastructure IA ?

Brice Geoffroy : Chez Inside, notre accompagnement commence toujours par un audit de l’existant et un cadrage précis des besoins. L’objectif est de définir une architecture cible qui soit adaptée au contexte métier et aux ambitions IA du client. Nous intervenons sur l’ensemble des briques de l’infrastructure présentées : conception de l’infrastructure et évaluation des exigences de sécurité, aide au choix des technologies, providers Cloud et des outils, support à l’automatisation DevOps (Terraform, Ansible…), développement d’applications spécifiques IA, et bien sûr pilotage de la gouvernance, MCO et assistance à l’administration.

Benjamin Messiaen : Ce qui nous distingue aussi, c’est notre approche de co-construction. Nous ne vendons pas une solution figée ou un produit clé en main. Nous travaillons main dans la main avec nos clients, en construisant l’infrastructure qui répond à leurs besoins réels, en fonction de leur contexte technique et de leur budget. Cela évite de devoir tordre un outil standard pour qu’il s’adapte. Cette méthode facilite aussi l’évolutivité des infrastructures IA : elles sont pensées dès le départ pour s’adapter et se renforcer au fil des usages.

Notre laboratoire IAxLab renforce d’ailleurs cette approche en offrant un espace d’expérimentation et d’innovation pour tester les architectures, réaliser des Proof of Concept IA et accompagner nos clients de la phase d’exploration jusqu’à l’industrialisation.

Vous souhaitez concevoir une infrastructure IA adaptée à votre contexte ?